超級人工智慧之路:人類的不朽或滅絕?

Tim Urban 是 Wait But Why 網站的創始人之一,該網站主要以長篇部落格的形式探討各種主題,內容涵蓋人工智能、外太空和拖延症等領域。他曾在 2016 年的 TED Talk 中探討拖延症的主題,該演講基於 Blog 中的概念,截至 2022 年 12 月,該演講已經累積了超過 5000 萬的觀看次數。網站上的一篇有關 Elon Musk 和 Neuralink 的文章是與 Musk 本人共同製作的。

Tim Urban 這兩篇關於 AI 人工智慧的文章值得人類對於 ChatGPT 的出現後對未來將產生的變化深思,更了不起的是,這還是 2015 年的文章!

它提出了一個現實而令人不安的問題:當超級人工智慧的時代來臨時,我們是否能掌握住未來的命運?文章引用了大量的研究和數據,用通俗易懂的方式解釋了人工智慧技術的發展,以及可能帶來的種種後果。

通過閱讀這篇文章,我們可以更好地了解和思考自己在這個時代的位置,以及人類作為一個物種的未來前景。我強烈推薦大家閱讀原文,深入探索這個時代的未知領域,從而更好地準備和應對未來的挑戰,這篇文章中的文字與圖片總結自此(推薦閱讀原文):

- The Artificial Intelligence Revolution: Part 1 - Wait But Why

- The Artificial Intelligence Revolution: Part 2 - Wait But Why

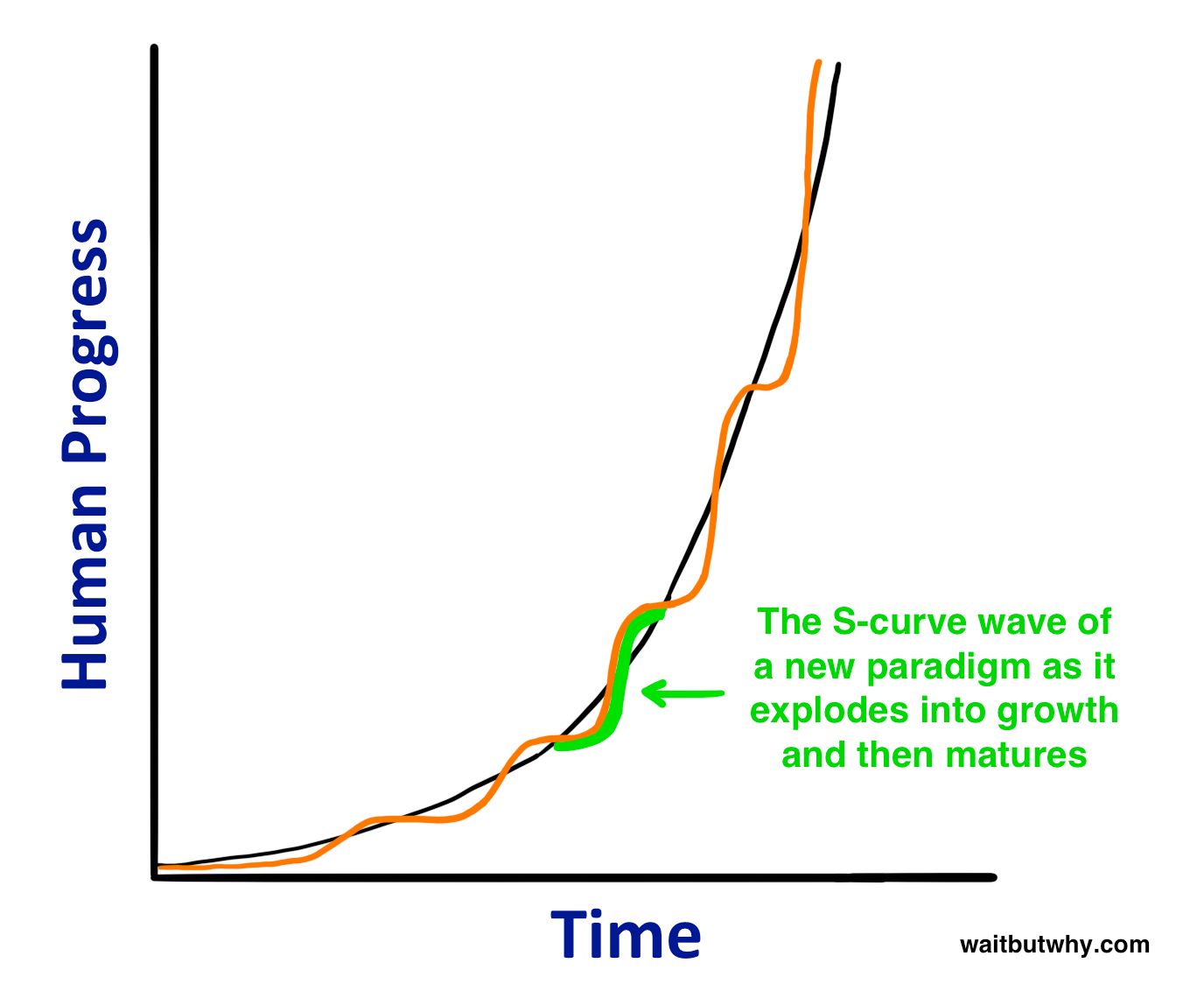

技術演進的 S 曲線

技術 S 曲線會經歷三個階段:

- 緩慢增長(指數增長的早期階段)

- 快速增長(指數增長的後期爆炸性階段)

- 隨著特定範式的成熟而趨於平穩

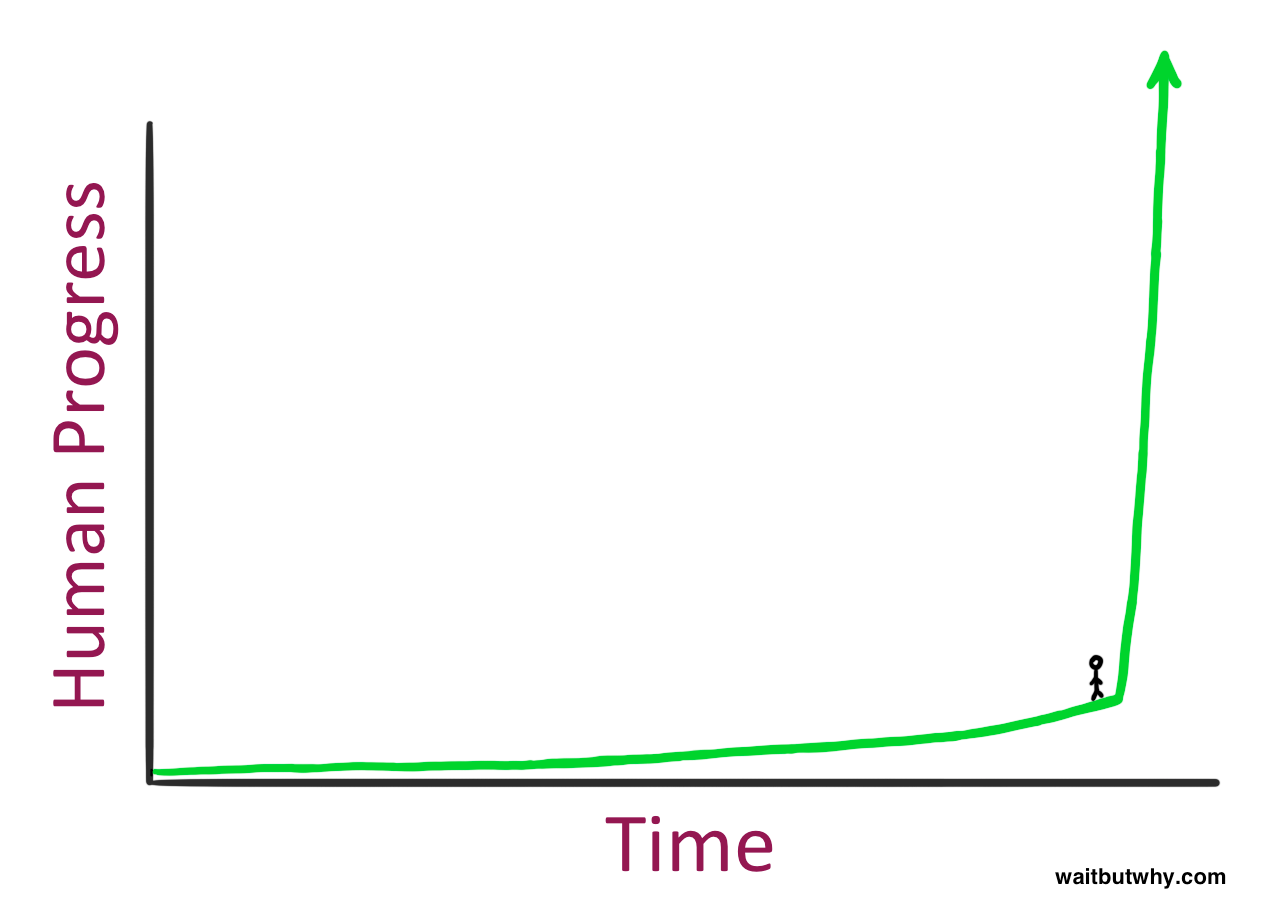

當我們試圖想像未來 30 年的進步時,我們通常會回顧過去 30 年的進展,並把它作為預測未來的基準。然而,這樣的方法會忽略指數增長的可能性,而往往只能採用線性方式思考。對於那些更聰明的人,他們可能會基於當前的進展速度,預測未來 30 年的發展,而不是僅僅依靠過去 30 年的發展。

我們對未來的想象是基於我們個人的經驗和觀察,這些經驗也會影響我們對事物發展速度的預期。然而,這樣的想像力往往受到經驗和想像力的限制,並不足以提供關於未來的準確思考工具。如果我們將未來的預測與我們現有的經驗相矛盾,我們往往會認為這樣的預測是不切實際的。然而,過去的經驗不能完全反映未來的可能性,因為指數增長可能會在某個時刻加速。

舉例來說,如果我們將目光投向過去,1995 年至 2007 年這段時間見證了互聯網的爆炸式增長,微軟、谷歌和 Facebook 進入公眾意識,社交網絡的誕生,以及手機和智能手機的問世。這是技術演進 S 曲線的第 2 階段,增長突飛猛進部分。但是,在 2008 年至 2015 年期間,開創性的進展較少,至少在技術方面是這樣。因此,如果我們只看最近的歷史,我們可能無法全面地理解事物發展的速度。

我們往往會受到自己的想像力所限制。我們對未來的看法往往是基於我們已有的經驗和觀察,這些經驗和觀察也會影響我們對事物發展速度的預期。而這種想像力往往無法全面反映未來的可能性。因此,如果我們將未來的預測與我們現有的經驗相矛盾,我們往往會認為這樣的預測是不切實際的。如果有人預測我們可能會活到 150 歲、250 歲,甚至不死,這樣的預測可能會被認為是荒誕不經。然而,飛機的發明和日心說的提出也被認為是荒誕不經,但這些發明和發現的出現改變了我們對世界的看法,顯示了未來的可能性。

智能爆炸:人工智慧的 S 曲線

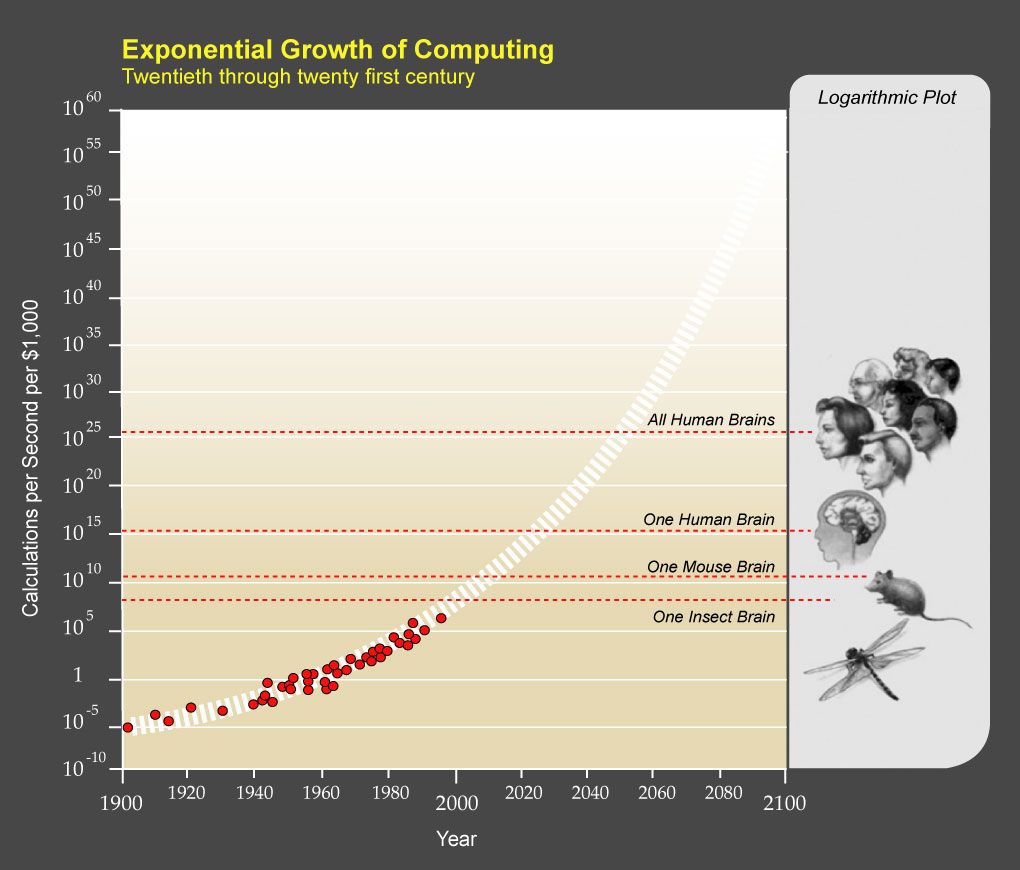

再來回看人工智慧的 S 曲線。一個新的、巨大的第二階段增長突飛猛進可能正在醞釀之中,並且硬體的快速發展和軟體的創新是同步發生的,這也可能會導致強人工智慧提前出現。儘管開始時進展緩慢,但是在後期,進展可能會突飛猛進。此外,軟體的進展可能看起來緩慢,但是在某個關鍵時刻,一個小小的創新可能會改變進展的速度,類似於日心說對科學進展的貢獻。因此,即使創造一個能自我改進的電腦對我們來說很遙遠,但是一個小小的變動可能會讓現有的系統變得更強大,推動人工智慧向人類智慧的衝刺。

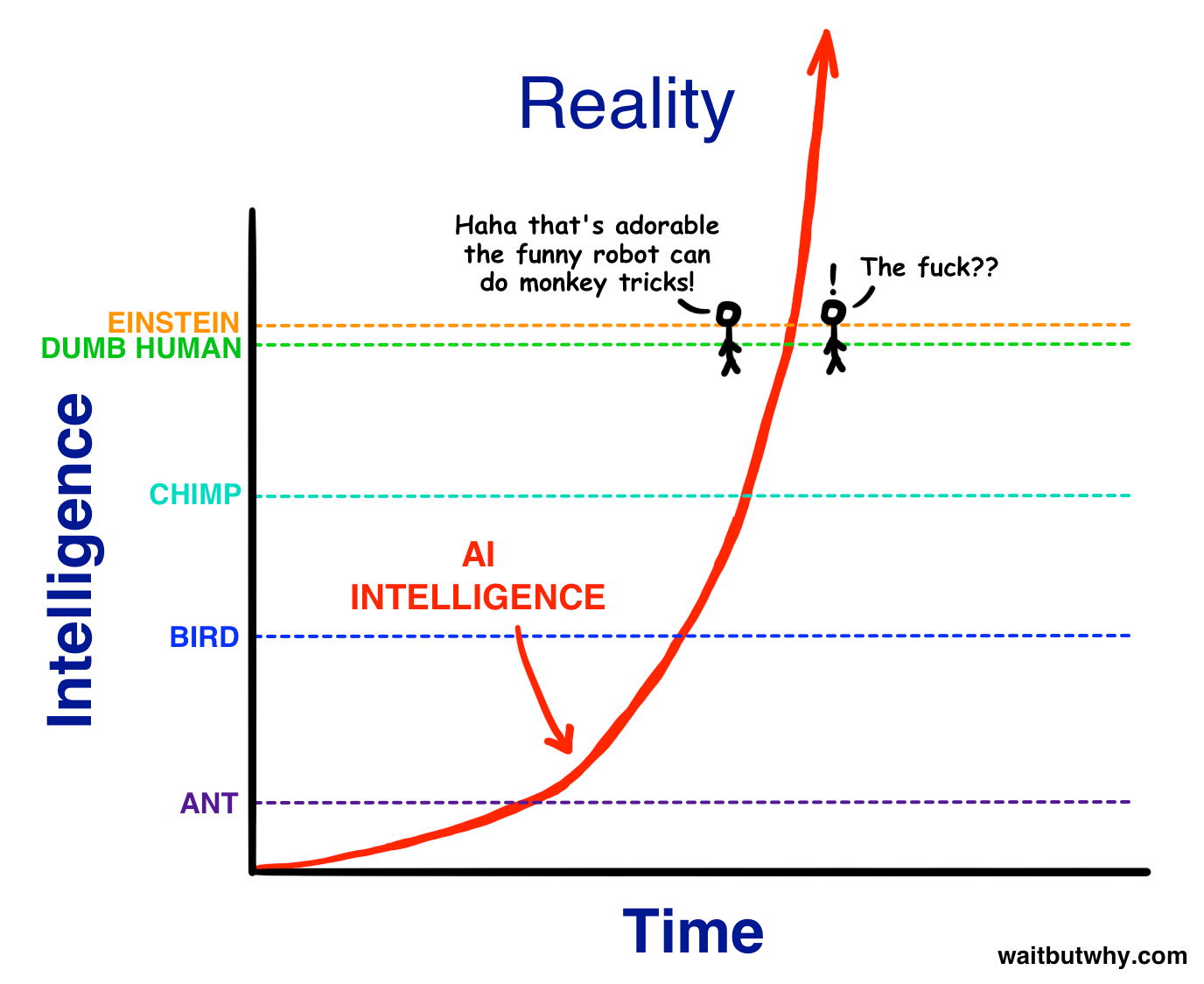

當人工智慧逐漸變得更加智能時,我們看到的是它像一個動物一樣逐步變得更加智能。然後,它突然達到了幼童的程度,我們到時也許會感慨:「看這個人工智慧就跟幼童一樣聰明,真可愛。」

但問題是,從智能的整體看,人和人的智能差別,比如從最愚笨的人類到愛因斯坦的差距,實際上並不大。所以當人工智慧達到腦殘級別的智能後,它會很快變得比愛因斯坦更聰明,接著會進一步提升智能水平。這種提升的過程形成的曲線,就被稱為人工智慧的 S 曲線。它的初始增長速度比較緩慢,然後逐漸加速,最後達到了指數級的增長,這就是智能爆炸。

S 曲線預示著人工智慧發展的爆炸式增長,它的起點可能會讓我們感到驚訝,但是當它快速提升到超越人類智能的水平時,它可能將帶來巨大的影響。在人類語言中,我們將 130 的智商稱為聰明,將 85 的智商稱為愚蠢,但我們無法形容 12952 的智商,因為人類語言中並沒有這個概念。一旦強人工智慧被創造出來,它將是地球有史以來最強大的東西,而所有生物,包括人類,都只能屈居其下。

AI 的定義,發展三階段

- 狹義人工智慧(ANI, Artificial Narattive):狹義人工智慧是專門研究某一領域的人工智慧,它能夠在特定的領域中執行特定的任務。舉例來說,一個能夠在國際象棋中擊敗世界象棋冠軍的 AI,僅具備在國際象棋領域中的特定能力,無法解決其他領域的問題,如在硬碟上儲存資料的更好方法。

- 廣義人工智慧(AGI):廣義人工智慧是指具有人類級別智能,能夠執行任何智力任務的機器。它將能夠像人類一樣推理、計劃、解決問題、抽象思考、理解複雜思想、快速學習和從經驗中學習的能力。創建 AGI 要比創建 ANI 更加困難,因為它需要模擬人類大腦的整體功能。目前還沒有創建出 AGI。

- 超級人工智慧(ASI):超級人工智慧是一種在幾乎所有領域都比最優秀的人類大腦聰明得多的智能,包括科學創造力、一般智慧和社交技能。從只比人類聰明一點點的計算機到比人類聰明數萬億倍的計算機都是超級人工智慧的範圍。目前還沒有創建出 ASI。

以上是 AI 發展的三個階段,從 ANI 到 AGI,再到 ASI。現在,我們已經能夠通過多種方式征服 ANI,而且它已經無處不在。AI 革命是從 ANI,通過 AGI,到 ASI 的道路。這是一條可能改變一切,甚至可能讓人類生存都受到威脅的道路。

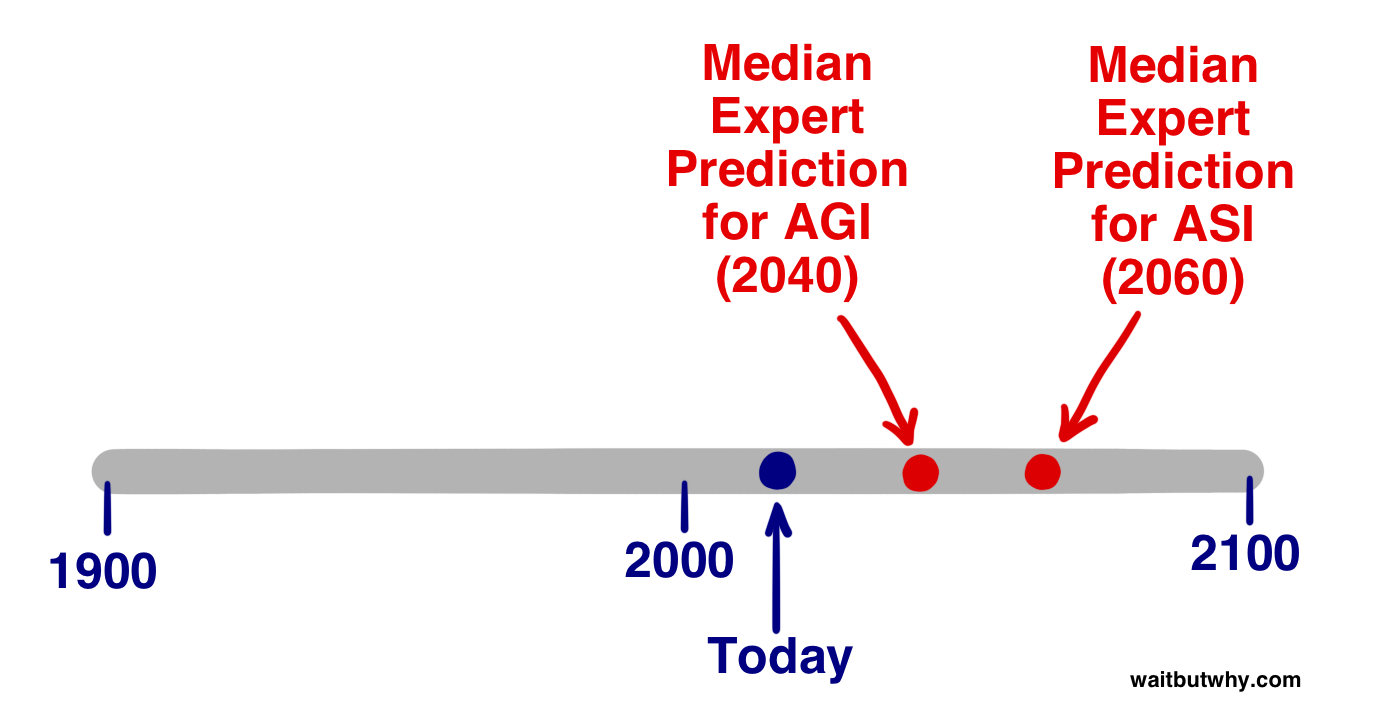

專家對於達到各個階段時間軸的不同看法

在達到人工智慧的各個階段上,專家們有不同的看法。2013 年,穆勒和博斯特羅姆進行了調查,詢問數百名人工智慧專家,到哪一年會有 10% / 50% / 90% 的機會獲得 AGI 的存在。根據統計資料,中位數參與者認為,到 2022 年有 10% 的機會獲得 AGI 的存在,到 2040 年有 50% 的機會,到 2075 年有 90% 的機會。

最近,作者詢問了另一組參與者,他們認為 AGI 何時會實現,結果顯示,到 2030 年 42% 的受訪者認為 AGI 將實現,到 2050 年 25%,到 2100 年 20%,2100 年後 10%,從不 2%。對於 ASI,穆勒和博斯特羅姆問專家們,AGI 到 ASI 的快速(2 年)過渡的可能性只有 10%,但在 30 年或更短的時間內,過渡的可能性為 75%。綜合以上結果,中間意見顯示,專家們認為 AGI 到 ASI 過渡的最現實的猜測是 2060 年。

試想,超人工智慧的到來

時間會繼續流逝,但衰老卻不一定如此。衰老是身體物理材料的磨損,就像汽車隨著時間推移而磨損一樣,但汽車的老化可以通過修理或更換零件而避免。人體也是一樣的,只不過更複雜。

未來,如果我們擁有技術,就能夠使用智能納米機器人來執行許多任務,例如定期修復或更換身體任何部位磨損的細胞,甚至能夠逆轉衰老。這樣的技術可以創造一個完全不同的人類體驗,將人的能力推到前所未有的高度。比如:

- 60 歲的人可能可以使用一個「年齡恢復器」步入裡面,然後帶著一個 30 歲的身體走出來。甚至大腦也可以被智能超越的東西重新設計,而不會影響個性或記憶等方面。這意味著一個 90 歲患有痴呆症的老人可能會像大頭針一樣敏銳地走出來,準備開始一個全新的職業生涯。

- 人造材料將在未來融入人體,取代器官,比如用完善的紅細胞納米機器人代替紅細胞,這些納米機器人可以為自己提供動力,完全不需要心臟。甚至大腦也可以被增強,讓人類能夠比現在思考快數十億倍並獲取外部信息,因為大腦的人工添加物將能夠與人交流雲中的所有信息。

- 可以完美地改善身體的食物和性:納米機器人可以為身體細胞提供完美的營養,並智能地引導任何不健康的東西通過身體而不影響任何東西。這意味著未來我們可能可以像對待性一樣對待食物,享受食物帶來的快樂而不必擔心健康問題。

這些例子展示了未來人類可能會擁有的新能力,而這些能力的實現得益於超級智能的發展。超人工智慧可以進行各種任務,包括消除疾病、貧困、環境破壞和各種痛苦,逆轉衰老過程,或者為我們提供上傳自我的選項,從而給我們無限的壽命。超人工智慧可以幫助我們創造一個極具吸引力的體驗世界,在這個世界中,我們可以過著快樂的生活,玩遊戲,相互聯繫,體驗,個人成長,讓生活更接近我們的理想。

人類是否會自取滅亡?

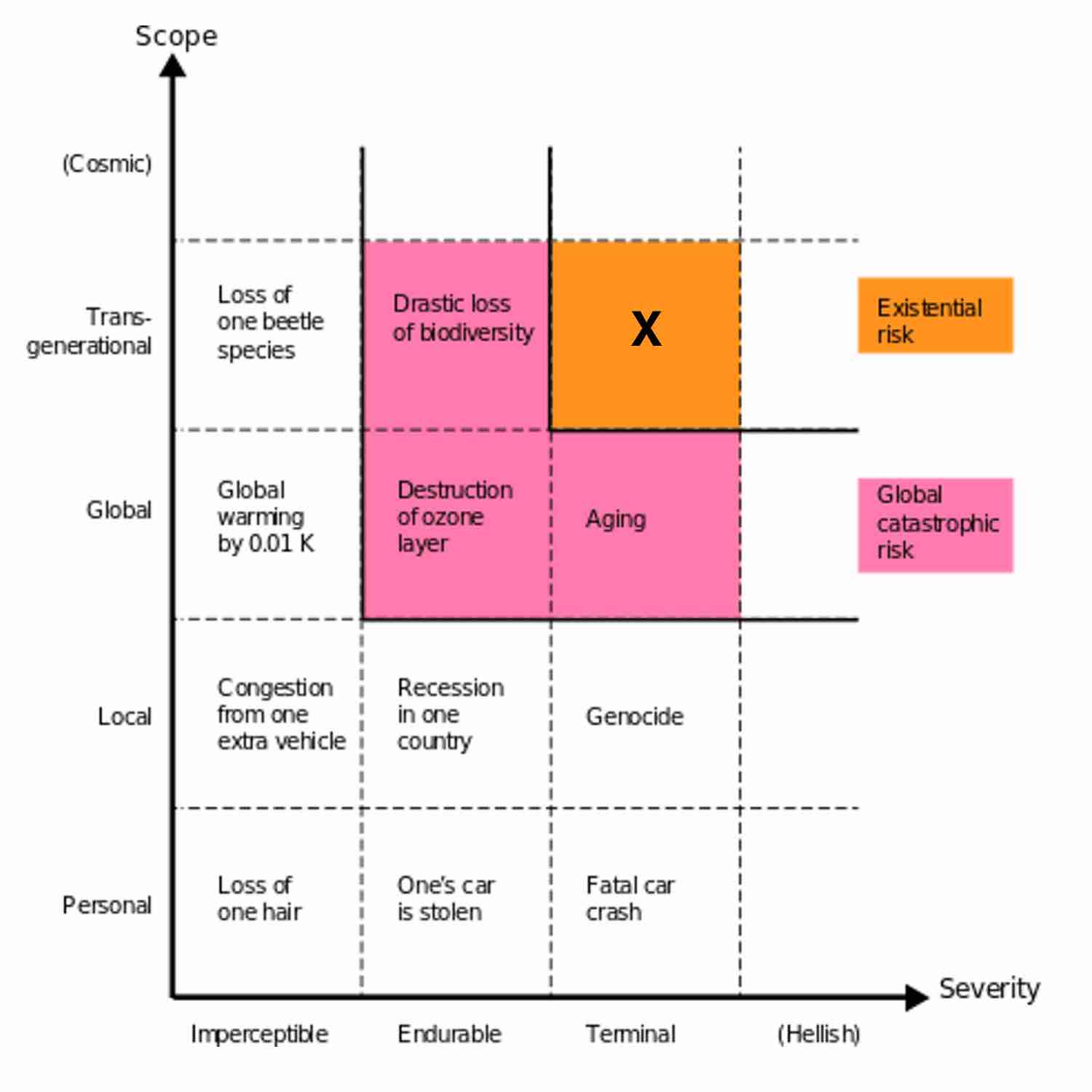

在圖上右上角我們可以看到,存在風險 這個標籤是為跨越物種、跨越世代並且其後果是毀滅性的,我們通常談論的是滅絕,這是三種可能的情況會導致人類生存災難:

- 自然環境的變化:例如大型小行星碰撞、使空氣對人類不宜的大氣層變化、席捲全球的致命病毒或細菌性疾病等。

- 外星人的入侵:這是斯蒂芬・霍金、卡爾・薩根和許多其他天文學家擔心的事情,他們建議「訊息外洩技術」停止向外發射信號。他們不想讓我們成為像原住民一樣的存在,讓所有潛在的外星征服者都知道我們的存在。

- 人類自取滅亡:恐怖分子手握可能導致滅絕的武器,一場災難性的全球戰爭,或是人類匆忙創造出比自己更聰明的東西,而沒有事先仔細思考。

哲學家 Bostrom 的觀點,認為如果在過去的 10 萬年中人類未被自然災害或外星人滅絕,那麼在未來的一個世紀中,人類也不太可能被這些原因滅絕。

Bostrom 使用彈珠比喻來解釋人類創新的風險。他將一堆彈珠放進一個甕裡,大多數是白色的,少數是紅色的,還有極少數是黑色的。每次人類創造新的技術或產品,就像是從甕中取出一顆彈珠。大多數創造都是中性的或對人類有幫助的 —— 那些是白色彈珠。有些創造可能會對人類有害,如大規模殺傷性武器,但它們不會造成人類的滅亡 —— 這些是紅色彈珠。然而,如果我們要創造某些東西導致我們滅亡,那就是從甕中取出稀有的黑色彈珠。

目前為止,我們還沒有取出黑色彈珠,因為我們還活著並且在創造新事物。但 Bostrom 認為,當人工超級智能到來時,這將成為我們迄今為止最強大的黑色彈珠候選者。因為超級智能擁有的力量和能力是我們無法理解的,它們可能會對人類產生意想不到的威脅,甚至導致人類的滅亡。

因此,Bostrom 指出,如果要防止人工超級智能導致人類的滅亡,我們需要提前識別和防範可能的風險,並開始採取行動。

AI 是否會是一個仁慈的上帝?

超人工智慧將能夠掌控所有原子的位置,從而實現許多看似超自然的事情,例如治療各種不治之症、解決世界飢荒,甚至讓人類永生,但同樣也可能帶來地球上所有生命的終結。一旦超人工智慧誕生,對人類來說就像全能的上帝降臨地球一般,我們必須非常謹慎地發展和管理超人工智慧,以確保它對人類和地球的未來有益而非有害。

當人類擁有了超人工智慧,這可能將是人類做出的最後一項發明。

這時候我們所關心的就是,”祂”是否會是一個仁慈的上帝?